Auflösung in der Bildverarbeitung

Autoren: Gregory Hollows, Nicholas James

Dies ist der Abschnitt 2.2 des Leitfadens zur Bildverarbeitung.

Bei der Auflösung handelt es sich um die Fähigkeit eines Bildverarbeitungssystems Objektdetails abzubilden. Sie kann durch Faktoren wie die Art der verwendeten Beleuchtung, die Sensorpixelgröße und die Eigenschaften der Optik beeinflusst werden. Je kleiner der Objektausschnitt ist, desto höher ist die erforderliche Auflösung.

Dividiert man die Anzahl der horizontalen oder vertikalen Pixel auf einem Sensor durch die Größe des Objekts, das man betrachten möchte, so erhält man einen Hinweis darauf, wie viel Fläche jeder Pixel auf dem Objekt abdeckt, und kann damit die Auflösung abschätzen. Dadurch wird real jedoch nicht festgestellt, ob die Informationen auf dem Pixel von den Informationen auf anderen Pixeln unterscheidbar sind.

Es ist wichtig zu verstehen, was die Systemauflösung einschränken kann. Abbildung 1 zeigt zwei Quadrate auf weißem Hintergrund. Wenn die Quadrate auf benachbarte Pixel des Kamerasensors abgebildet werden, erscheinen sie als ein großes Rechteck (a) und nicht als zwei separate Quadrate (b). Um die Quadrate zu unterscheiden, muss mindestens ein Pixel zwischen ihnen liegen. Dieser Mindestabstand ist die Grenzauflösung des Systems. Die absolute Zahl dieser Grenze wird durch die Größe der Pixel auf dem Sensor und die Anzahl der Pixel auf dem Sensor definiert.

Abbildung 1: Auflösen von zwei Quadraten: Wenn der Abstand zwischen den Quadraten zu klein ist (a), kann der Kamerasensor sie nicht als separate Objekte auflösen.

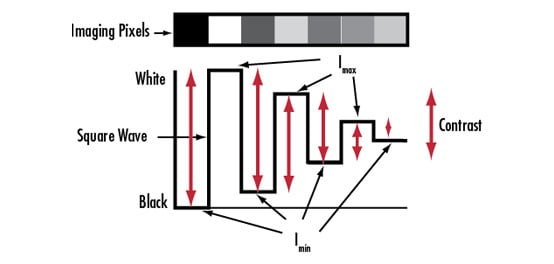

Das Linienpaar und die Sensorgrenzen

Die Auflösung wird oft als Dimension angegeben. Dieses Konzept der Auflösung als Mindestgröße, die von einem Objektiv oder System aufgelöst werden kann, ist keine vollständige Beschreibung der Auflösung. Eine genauere Beschreibung der Auflösung ist eine Frequenz, gemessen in Linienpaaren pro Millimeter $ \left[ \small{\tfrac{\text{lp}}{\text{mm}}} \right] $. Ein Linienpaar ist ein Paar aus schwarzen und weißen Quadraten im Objektraum. Die Auflösung eines Objektivs ist leider nicht absolut. Bei einer bestimmten Auflösung hängt die Fähigkeit, die beiden Quadrate als getrennte Einheiten darzustellen, von den Graustufen ab. Ein System kann ein Linienpaar leichter auflösen, wenn der Unterschied zwischen den Graustufen der Quadrate und des Raums zwischen ihnen größer ist (Abbildung 1b). Dieser Graustufenunterschied wird als Kontrast bezeichnet. Die Auflösung ist also definiert als eine Ortsfrequenz, angegeben in $ \left[ \small{\tfrac{\text{lp}}{\text{mm}}} \right] $, bei der ein bestimmter Kontrast erreicht wird.

Der Kontrast wird je nach Objektiv- und Kamerahersteller unterschiedlich festgelegt, ist aber bei Objektiven in der Regel mit 20% spezifiziert. Aus diesem Grund ist die Berechnung der Auflösung in Form von $ \left[ \small{\tfrac{\text{lp}}{\text{mm}}} \right] $ äußerst nützlich beim Vergleich von Objektiven und bei der Bestimmung der besten Wahl für bestimmte Sensoren und Anwendungen (weitere Informationen finden Sie unter Kontrast).

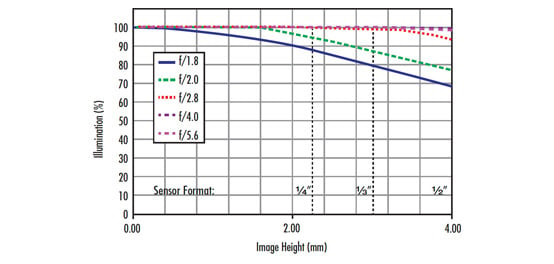

Der Sensor ist der Ausgangspunkt für die Berechnung der Systemauflösung. Wenn Sie mit dem Sensor beginnen, ist es einfacher, die erforderliche Objektivleistung zu bestimmen, die zu dem Sensor oder anderen Anwendungsanforderungen passt. Die höchste von einem Sensor auflösbare Frequenz, die Nyquist-Frequenz, beträgt effektiv zwei Pixel oder ein Linienpaar. Tabelle 1 zeigt die Nyquist-Grenze in Verbindung mit Pixelgrößen, die auf einigen gängigen Sensoren zu finden sind. Die Auflösung des Sensors $ \left( \xi _{\small{\text{Sensor}}} \right) $, die als Bildraumauflösung des Systems $ \left( \xi _{\small{\text{Bildraum}}} \right) $ bezeichnet wird, wird berechnet, indem die Pixelgröße (s), normalerweise in Mikrometern angegeben, mit 2 multipliziert wird (um ein Paar zu bilden) und durch 1000 geteilt wird, um in mm umzurechnen:

Sensoren mit größeren Pixeln haben eine geringere Grenzauflösung. Sensoren mit kleineren Pixeln haben eine höhere Grenzauflösung. Eine Erläuterung, wie diese Informationen zur Bestimmung der erforderlichen Objektivleistung verwendet werden, finden Sie unter Sensorleistung und Grenzen. Die Grenzauflösung bezogen auf das zu betrachtende Objekt kann über die Beziehungen zwischen der Sensorgröße, dem Bildfeld (FOV) und der Anzahl der Pixel auf dem Sensor berechnet werden.

Die Sensorgröße ist die Größe der aktiven Fläche eines Kamerasensors, die durch die Sensorformatgröße angegeben wird (weitere Informationen zum Sensorformat finden Sie unter Sensoren). Die genauen Sensorproportionen variieren jedoch je nach Seitenverhältnis, sodass die nominalen Sensorformate nur als Richtlinie verwendet werden sollten, insbesondere für telezentrische Objektive und Objektive mit hoher Vergrößerung. Die Sensorgröße (H) (horizontal, vertikal oder diagonal) kann direkt aus der Pixelgröße und der Anzahl der aktiven Pixel auf dem Sensor (p) berechnet werden.

| Pixelgröße (µm) | Zugehörige Nyquist-Grenze $ \left( \tfrac{\text{lp}}{\text{mm}} \right) $ |

|---|---|

| 1,67 | 299,4 |

| 2,2 | 227,3 |

| 3,45 | 144,9 |

| 4,54 | 110,1 |

| 5,5 | 90,9 |

Tabelle 1: Mit zunehmender Pixelgröße nimmt die zugehörige Nyquist-Grenze in $ \left[ \small{\tfrac{\text{lp}}{\text{mm}}} \right] $ proportional ab.

Auflösung im Objektraum

Um den absolut kleinsten auflösbaren Punkt zu bestimmen, der auf dem Objekt zu sehen ist, muss das Verhältnis des FOV zur Sensorgröße berechnet werden. Dies wird auch als Systemvergrößerung bezeichnet.

Die Systemvergrößerung skaliert die Bildraumauflösung auf die Objektraumauflösung $ \left( \xi _{\small{\text{Objektraum}}} \right) $.

Bei der Entwicklung einer Anwendung wird die Objektraumauflösung eines Systems typischerweise als Längenmaß und nicht in $ \left[ \small{\tfrac{\text{lp}}{\text{mm}}} \right] $ spezifiziert. Es gibt zwei Möglichkeiten, diese Umwandlung vorzunehmen:

Die letzte Formel ist eine einfache Möglichkeit die Grenzauflösung des Objekts zu bestimmen. Für die Objektivauswahl ist es sehr hilfreich die Bildraumauflösung und die Vergrößerung zu kennen. Es ist auch wichtig zu beachten, dass viele zusätzliche Faktoren beteiligt sind und die reale Grenzauflösung oft viel niedriger ist als das, was mit den Gleichungen leicht berechnet werden kann. Erfahren Sie mehr über Kontrastgrenzen und Objektivauswahl in Kontrast und Objektivtypen in der Bildverarbeitung.

Beispielrechnungen für Auflösung und Vergrößerung mit dem ICX625-Sensor von Sony

Bekannte Parameter:

Pixelgröße: 3,45 × 3,45 μm

Anzahl der Pixel: 2448 × 2050

Gewünschtes FOV (horizontal): 100 mm

Grenzauflösung des Sensors:

\begin{align} \xi_{\small{\text{Bildraum}}} & = \left( \frac{1}{2 \times s} \right) \times \left( \frac{1000 \large{\unicode[Cambria Math]{x03BC}} \normalsize{\text{m}}}{1 \text{mm}} \right) \\ & = \left( \frac{1}{2 \times 3,45 \large{\unicode[Cambria Math]{x03BC}} \normalsize{\text{m}}} \right) \times \left( \frac{1000 \large{\unicode[Cambria Math]{x03BC}} \normalsize{\text{m}}}{1 \text{mm}} \right) \approx 145 \tfrac{\text{lp}}{ \text{mm}} \end{align}

Sensorgröße:

$$ H_{\small{\text{horizontal}}} = 3,45 \large{\unicode[Cambria Math]{x03BC}} \normalsize{\text{m}} \times 2448 \times \left( \frac{1 \text{mm}}{1000 \large{\unicode[Cambria Math]{x03BC}} \normalsize{\text{m}}} \right) = 8,45 \text{mm} $$

$$ H_{\small{\text{vertikal}}} = 3,45 \large{\unicode[Cambria Math]{x03BC}} \normalsize{\text{m}} \times 2050 \times \left( \frac{1 \text{mm}}{1000 \large{\unicode[Cambria Math]{x03BC}} \normalsize{\text{m}}} \right) = 7,07 \text{mm} $$

Vergrößerung:

$$ m = \frac{8,56 \text{mm}}{100 \text{mm}} = 0,0845X $$

Auflösung:

$$ \xi_{\small{\text{Objektraum}}} \left[ \large{\unicode[Cambria Math]{x03BC}} \normalsize{\text{m}} \right] = 145 \tfrac{\text{lp}}{\text{mm}} \times 0,0845 = 12,25 \tfrac{\text{lp}}{\text{mm}} \approx 41 \large{\unicode[Cambria Math]{x03BC}} \normalsize{\text{m}} $$

Vorheriger Abschnitt

Vorheriger Abschnitt

weitere regionale Telefonnummern

ANGEBOTSTOOL

Geben Sie zum Starten die Produktnummer ein.

Copyright 2023 | Edmund Optics Inc. vertreten durch Edmund Optics GmbH, Isaac-Fulda-Allee 5, 55124 Mainz, Deutschland

Die Edmund Optics GmbH Deutschland fungiert als Handelsvermittler für die Edmund Optics Ltd. in Großbritannien.

Vertragspartner ist die Edmund Optics Ltd. in Großbritannien.