Sensoren und Objektive

Dies ist der Abschnitt 6.4 des Leitfadens zur Bildverarbeitung.

Bildgebung bei der Nyquist-Frequenz

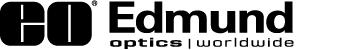

Es kann verlockend erscheinen, bei der sogenannten Nyquist-Frequenz abzubilden, die in Gleichung 1 aus Objektivauswahl - erweiterte Informationen definiert ist. Bei einer solchen Abbildung müsste das interessante Detail allerdings genau auf einen Pixel fallen. Würde sich das Abbildungssystem nur um einen halben Pixel verschieben, würde das Detail zwischen zwei Pixeln liegen und völlig verschwimmen. Somit ist die Abbildung bei der Nyquist-Frequenz in der Regel nicht geeignet und zielführend. Unter der Annahme, dass keine Subpixel-Interpolation verwendet wird, wird empfohlen, mit der halben Nyquist-Frequenz abzubilden, da so das interessante Detail immer mindestens zwei Pixel einnimmt.

Eine weitere, oft unzutreffende, Annahme ist, dass ein Objektiv nur dann für die Verwendung mit einer bestimmten Kamera geeignet ist, wenn es bei der Nyquist-Frequenz des Sensors, mit dem es verwendet wird, einen hohen Kontrast (>20%) aufweist. Dies ist nicht der Fall, da, wie bereits erwähnt, eine Abbildung an der Nyquist-Grenze nicht ratsam ist und zu verschiedenen Problemen führen kann. Um festzustellen, ob ein Objektiv für einen bestimmten Kamerasensor geeignet ist oder nicht, muss das gesamte System und auch die spezifische Anwendung betrachtet werden. Im folgenden Text wird beschrieben, was in einem bildgebenden System geschieht, das bei oder nahe der Nyquist-Frequenz verwendet wird, und welche Auswirkungen dies auf die Gesamtauflösung des Systems hat.

Das Verständnis über das Zusammenwirken von Kamerasensoren und Objektiven ist ein wichtiger Aspekt beim Design, der Entwicklung und der Implementierung eines Bildverarbeitungssystems. Doch der Optimierung dieses Zusammenspiels wird oftmals zu wenig Bedeutung beigemessen, obwohl es entscheidenden Einfluss auf die Auflösung des Systems hat. Eine falsch gewählte Kombination aus Kamera und Objektiv kann darüber hinaus auch zu unnötig hohen Kosten führen. Leider ist es nicht immer einfach, das richtige Objektiv und die richtige Kamera für eine bestimmte Anwendung zu finden: Es werden immer mehr Kamerasensoren (und infolgedessen auch immer mehr Objektive) entwickelt und hergestellt, um die neuen Fertigungsmöglichkeiten zu nutzen und die Leistung zu steigern. Diese neuen Sensoren stellen die Objektive vor eine Reihe von Herausforderungen, die es zu bewältigen gilt, und machen die richtige Kombination von Kamera und Objektiv nicht immer einfach.

Die erste Herausforderung besteht darin, dass die Pixel immer kleiner werden. Während kleinere Pixel in der Regel eine höhere Auflösung auf Systemebene bedeuten, ist dies nicht immer der Fall, wenn die verwendeten Optiken ins Spiel kommen. In einer perfekten Welt, in der es keine Beugung oder optische Fehler in einem System gibt, würde die Auflösung einfach auf der Größe eines Pixels und der Größe des betrachteten Objekts basieren (siehe Auflösung). Ganz allgemein gesprochen steigt somit mit abnehmender Pixelgröße die Auflösung. Dieser Anstieg ist darauf zurückzuführen, dass kleinere Objekte auf kleineren Pixeln abgebildet werden können und der Abstand zwischen den Objekten immer noch auflösbar ist, auch wenn dieser Abstand abnimmt. Hierbei handelt es sich allerdings um ein stark vereinfachtes Modell der Objekterkennung durch einen Kamerasensor, bei dem Rauschen oder andere Parameter nicht berücksichtigt werden.

Auch für Objektive existieren Angaben zur Auflösung, aber diese sind nicht ganz so einfach zu verstehen wie bei Sensoren, da es keine konkreten Werte wie die Pixel gibt. Es gibt jedoch zwei Faktoren, die letztendlich die Kontrastwiedergabe (Modulationsübertragungsfunktion oder MTF) eines bestimmten Objektmerkmals auf einem Pixel bestimmen, wenn es durch ein Objektiv abgebildet wird: Beugung und Abbildungsfehler. Beugung tritt immer dann auf, wenn Licht durch eine Blende fällt, und führt zu einer Verringerung des Kontrasts (weitere Einzelheiten in Das Airy-Scheibchen und die Beugungsgrenze). Aberrationen sind Fehler, die in jedem abbildenden Objektiv auftreten und je nach Art der Aberration die Bildinformationen entweder verwischen oder verfälschen, wie in From Lens to Sensor beschrieben. Bei einem lichtstarken Objektiv (≤f/4) sind optische Aberrationen meist die Ursache dafür, dass ein System nicht so "perfekt" ist, wie es die Beugungsgrenze annehmen lässt; in den meisten Fällen „funktionieren“ Objektive einfach nicht bei ihrer theoretischen Grenzfrequenz ($ \small{\xi_{\small{\text{Cutoff}}}} $ ), die durch Gleichung 1 beschrieben ist.

Um diese Gleichung zu verdeutlichen, kann sie auf einen Kamerasensor übertragen werden: Mit zunehmender Häufigkeit der Pixel (die Pixelgröße nimmt ab) nimmt der Kontrast ab - jedes Objektiv wird diesem Verhalten folgen. Dies berücksichtigt jedoch nicht die tatsächliche Leistung eines Objektivs. Die Toleranzen und die Fertigung wirken sich auf die Aberrationen des Objektivs aus und die tatsächliche Leistung weicht von der nominellen, designten Leistung ab. Es kann schwierig sein, die Leistung eines realen Objektivs auf der Grundlage von Daten abzuschätzen, aber mithilfe von Tests in einem Bildverarbeitungslabor lässt sich feststellen, ob ein bestimmtes Objektiv und ein Kamerasensor kompatibel sind.

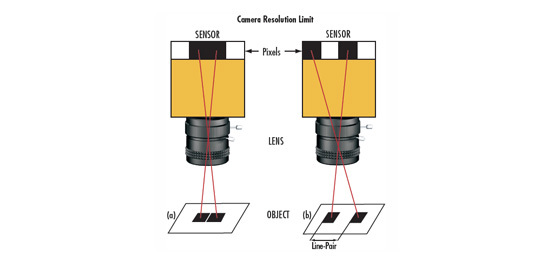

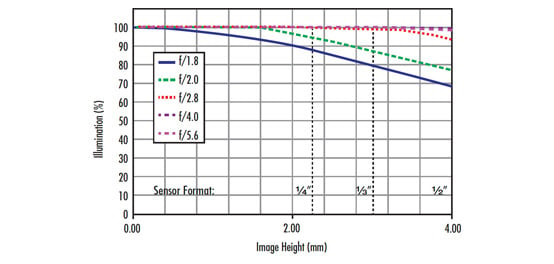

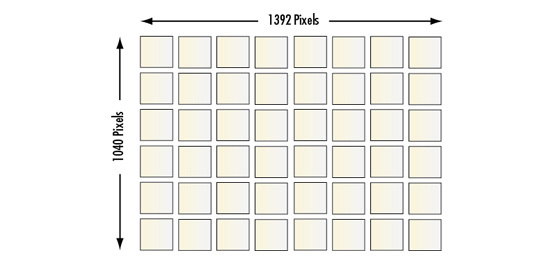

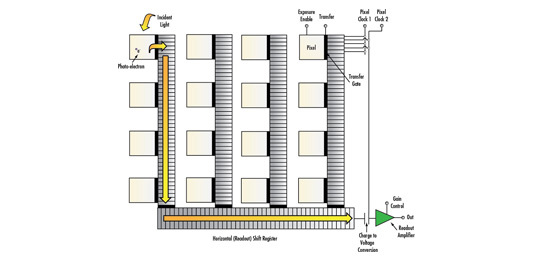

Eine Möglichkeit, die Leistung eines Objektivs mit einem bestimmten Sensor zu ermitteln, besteht darin, seine Auflösung mit einem USAF-1951-Testbild zu testen. Testbilder mit Balken eignen sich besser zur Bestimmung der Kompatibilität zwischen Objektiv und Sensor als Siemenssterne, da ihre Merkmale besser mit quadratischen (und rechteckigen) Pixeln übereinstimmen. Die folgenden Beispiele zeigen Testbilder, die mit demselben hochauflösenden 50-mm-Objektiv und unter denselben Lichtverhältnissen auf drei verschiedenen Kamerasensoren aufgenommen wurden. Jedes Bild wird dann mit der nominalen MTF-Kurve des Objektivs auf der Achse (blaue Kurve) verglichen. In diesem Fall wird nur die auf der Achse liegende Kurve verwendet, da der Bereich von Interesse, in dem der Kontrast gemessen wurde, in der Sensormitte liegt. Abbildung 1a zeigt die Leistung des 50-mm-Objektivs in Verbindung mit dem Sensor $ \scriptsize{^1 / _{2,5}}$" ON Semiconductor MT9P031 mit 2,2 µm großen Pixeln bei einer Vergrößerung von 0,177X.

Abbildung 1: Ein Vergleich der nominalen Objektivleistung mit der realen Leistung eines hochauflösenden 50-mm-Objektivs in Kombination mit (a) ON Semiconductor MT9P031 mit 2,2-μm-Pixeln, (b) Sony IXC655 mit 3,45-μm-Pixeln und (c) ON Semiconductor KAI-4021 mit 7,4-μm-Pixeln. Die rote, violette und dunkelgrüne Linie zeigt jeweils die Nyquist-Grenze der Sensoren. Die gelbe, hellblaue und hellgrüne Linie zeigt jeweils die Hälfte der Nyquist-Grenze der Sensoren.

Unter Verwendung von Gleichung 1 aus Auflösung beträgt die Nyquist-Auflösung des Sensors ($\xi_{\small{\text{Sensor}}}$) 227,7$ \small{ \tfrac{\text{lp}}{\text{mm}}} $, was bedeutet, dass das kleinste Objekt, welches das System theoretisch bei einer Vergrößerung von 0,177X abbilden könnte, 12,4 µm beträgt (ermittelt unter Verwendung einer anderen Form von Gleichung 1 aus Auflösung).

Beachten Sie, dass diese Berechnungen nicht mit einem Kontrastwert verbunden sind. Die Abbildungen in 1a zeigen die Bilder von zwei Elementen auf einem USAF-1951-Testbild; das linke Bild zeigt zwei Pixel pro Detail, das rechte Bild zeigt ein Pixel pro Detail. Bei der Nyquist-Frequenz des Sensors (227$ \small{ \tfrac{\text{lp}}{\text{mm}}} $) bildet das System das Testbild mit 8,8% Kontrast ab, was unter dem empfohlenen Mindestkontrast von 20% für ein zuverlässiges Abbildungssystem liegt. Man beachte, dass durch die Erhöhung der Detailgröße um den Faktor zwei auf 24,8 μm der Kontrast fast um den Faktor drei erhöht wird. In der Praxis wäre das Abbildungssystem bei der halben Nyquist-Frequenz viel zuverlässiger.

Die Schlussfolgerung, dass das Abbildungssystem ein Objektmerkmal von 12,4 µm Größe nicht zuverlässig abbilden kann, steht im direkten Widerspruch zu den Gleichungen zur Auflösung, da die Objekte mathematisch gesehen innerhalb der Möglichkeiten des Systems liegen. Dieser Widerspruch macht deutlich, dass Berechnungen erster Ordnung und Näherungen nicht ausreichen, um festzustellen, ob ein Abbildungssystem eine bestimmte Auflösung erreichen kann oder nicht. Darüber hinaus ist die Berechnung der Nyquist-Frequenz keine solide Grundlage für die Bestimmung des Auflösungsvermögens eines Systems und sollte nur als Richtwert für die Grenzen eines Systems verwendet werden. Ein Kontrast von 8,8% ist zu niedrig, um als genau zu gelten, da geringfügige Schwankungen der Bedingungen den Kontrast leicht auf ein nicht mehr auflösbares Niveau senken können.

Die Bilder in Abbildungen 1b und 1c sind ähnlich wie die Bilder des Sensors MT9P031, obwohl als Sensoren der Sony ICX655 (3,45 µm Pixel) und der ON Semiconductor KAI-4021 (7,4 µm Pixel) verwendet wurden. Die linken Bilder in jeder Abbildung zeigen zwei Pixel pro Merkmal und die rechten Bilder zeigen ein Pixel pro Merkmal. Der Hauptunterschied zwischen den drei Abbildungen besteht darin, dass alle Bildkontraste der Abbildungen 1b und 1c über 20% liegen, was (auf den ersten Blick) bedeutet, dass sie Merkmale dieser Größe zuverlässig auflösen können. Natürlich ist die Mindestgröße der Objekte, die sie auflösen können, größer als die 2,2 µm großen Pixel in Abbildung 1a. Die Abbildung mit der Nyquist-Frequenz ist jedoch nach wie vor nicht ratsam, da geringfügige Bewegungen des Objekts das gewünschte Merkmal zwischen zwei Pixel schieben könnten, wodurch das Objekt unauflösbar würde. Beachten Sie, dass mit zunehmender Pixelgröße von 2,2 µm über 3,45 µm bis hin zu 7,4 µm die jeweiligen Kontraststeigerungen von einem Pixel pro Merkmal auf zwei Pixel pro Merkmal weniger einflussreich sind. Beim ICX655 (3,45 µm Pixel) ändert sich der Kontrast um knapp Faktor 2, beim KAI-4021 (7,4 µm Pixel) wird dieser Effekt noch weiter abgeschwächt.

Abbildung 2: Bilder, die mit demselben Objektiv und unter denselben Lichtverhältnissen auf drei verschiedenen Kamerasensoren mit drei verschiedenen Pixelgrößen aufgenommen wurden. Die oberen Bilder wurden mit vier Pixeln pro Merkmal aufgenommen, die unteren Bilder mit zwei Pixeln pro Merkmal.

Eine wichtige Erkenntnis aus Abbildung 1 ist die Abweichung zwischen der nominellen MTF des Objektivs und dem realen Kontrast in einem tatsächlichen Bild. Die MTF-Kurve des Objektivs oben in Abbildung 1a zeigt, dass das Objektiv bei der Frequenz von 227l$ \small{ \tfrac{\text{lp}}{\text{mm}}} $ einen Kontrast von etwa 24% erreichen sollte, wobei der real erzeugte Kontrastwert 8,8% betrug. Zu diesem Unterschied tragen vor allem zwei Faktoren bei: die MTF des Sensors und die Toleranzen des Objektivs. Die meisten Sensorhersteller veröffentlichen keine MTF-Kurven für ihre Sensoren, aber sie haben im Grunde genommen die gleiche Form wie die des Objektivs. Da die MTF auf Systemebene ein Produkt der MTF aller Komponenten eines Systems ist, müssen die MTF des Objektivs und des Sensors miteinander multipliziert werden, um eine genauere Aussage über das Gesamtauflösungsvermögen eines Systems treffen zu können.

Wie bereits erwähnt, ist eine toleranzierte MTF eines Objektivs auch schon eine Abweichung vom Sollwert. Alle diese Faktoren zusammen verändern die erwartete Auflösung eines Systems, und eine MTF-Kurve eines Objektivs allein ist keine genaue Darstellung der Auflösung auf Systemebene.

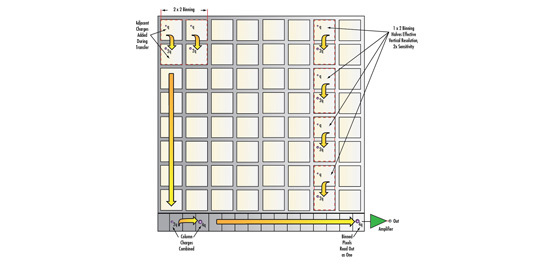

Wie in den Bildern in Abbildung 2 zu sehen ist, ist der Kontrast auf Systemebene bei den Bildern mit den größeren Pixeln am besten. Wenn die Pixelgröße abnimmt, sinkt der Kontrast erheblich. Eine bewährte Praxis ist die Verwendung von 20% als Mindestkontrast in einem Bildverarbeitungssystem, da jeder niedrigere Kontrastwert zu anfällig für Schwankungen des Rauschens ist, die durch Temperaturänderungen oder Übersprechen der Beleuchtung entstehen. Das mit dem 50-mm-Objektiv und den 2,2-µm-Pixeln aufgenommene Bild in Abbildung 1a hat einen Kontrast von 8,8% und dies ist zu niedrig, um sich auf die Bilddaten für Objektdetailgrößen zu verlassen, die der 2,2-µm-Pixelgröße entsprechen, da das Objektiv kurz davorsteht, zum begrenzenden Faktor des Systems zu werden. Sensoren mit Pixeln, die viel kleiner als 2,2 µm sind, gibt es zwar schon und sie sind auch recht beliebt, aber unterhalb dieser Größe ist es für die Optik fast unmöglich, bis auf die Ebene der einzelnen Pixel aufzulösen. Die unter Auflösung beschriebenen Gleichungen für die Bestimmung der Auflösung auf Systemebene wären hier praktisch bedeutungslos und Bilder, die denen in den oben gezeigten Abbildungen ähneln, könnten nicht aufgenommen werden. Die winzigen Pixel haben jedoch trotzdem einen Sinn - nur weil die Optik die kleinen Pixel nicht auflösen kann, sind sie nicht nutzlos. Bei bestimmten Algorithmen wie der Blob-Analyse oder der optischen Zeichenerkennung (OCR) geht es weniger darum, ob das Objektiv tatsächlich bis auf die Ebene einzelner Pixel auflösen kann, sondern vielmehr darum, wie viele Pixel über ein bestimmtes Merkmal gelegt werden können. Bei der Verwendung kleinerer Pixel kann eine Subpixel-Interpolation vermieden werden, was die Genauigkeit der durchgeführten Messungen erhöht. Außerdem ist der Auflösungsverlust beim Wechsel zu einer Farbkamera mit Bayer-Filter geringer.

Ein weiterer wichtiger Punkt ist, dass der Wechsel von einem Pixel pro Merkmal zu zwei Pixeln pro Merkmal einen erheblichen Kontrastgewinn mit sich bringt, insbesondere bei den kleineren Pixeln. Durch die Halbierung der Frequenz verdoppelt sich allerdings die Größe des minimal auflösbaren Objekts. Wenn es unbedingt notwendig ist die Einzelpixel-Ebene aufzulösen, ist es manchmal besser, die Vergrößerung der Optik zu verdoppeln und das Bildfeld (FOV) zu halbieren.

So deckt die Detailgröße dann doppelt so viele Pixel ab und der Kontrast wird stark erhöht. Der Nachteil dieser Lösung ist, dass weniger von dem gesamten Feld sichtbar ist. Aus Sicht des Bildsensors ist es am besten, die Pixelgröße beizubehalten und die Formatgröße des Bildsensors zu verdoppeln. Ein Bildgebungssystem mit 1facher Vergrößerung, das einen ½"-Sensor mit 2,2-µm-Pixeln verwendet, hat beispielsweise das gleiche Bildfeld und die gleiche Ortsauflösung wie ein System mit 2facher Vergrößerung, das einen 1"-Sensor mit 2,2-µm-Pixeln verwendet, aber bei dem 2fach-System ist der Kontrast theoretisch doppelt so hoch.

Leider bringt die Verdoppelung der Sensorgröße zusätzliche Probleme für die Objektive mit sich. Einer der wichtigsten Kostentreiber eines Objektivs ist die Sensorgröße, für die es entwickelt wurde. Die Entwicklung eines Objektivs für einen größeren Sensor erfordert mehr und größere optische Einzelkomponenten und die Toleranzen des Systems müssen enger sein. Um beim obigen Beispiel zu bleiben: Ein Objektiv für einen 1“-Sensor kann das Fünffache eines Objektivs für einen ½“-Sensor kosten, auch wenn es nicht die gleiche pixelgenaue Auflösung erreicht.

Vorheriger Abschnitt

Vorheriger Abschnitt

weitere regionale Telefonnummern

ANGEBOTSTOOL

Geben Sie zum Starten die Produktnummer ein.

Copyright 2023 | Edmund Optics, Ltd Unit 1, Opus Avenue, Nether Poppleton, York, YO26 6BL, UK

Die Edmund Optics GmbH Deutschland fungiert als Handelsvermittler für die Edmund Optics Ltd. in Großbritannien.

Vertragspartner ist die Edmund Optics Ltd. in Großbritannien.